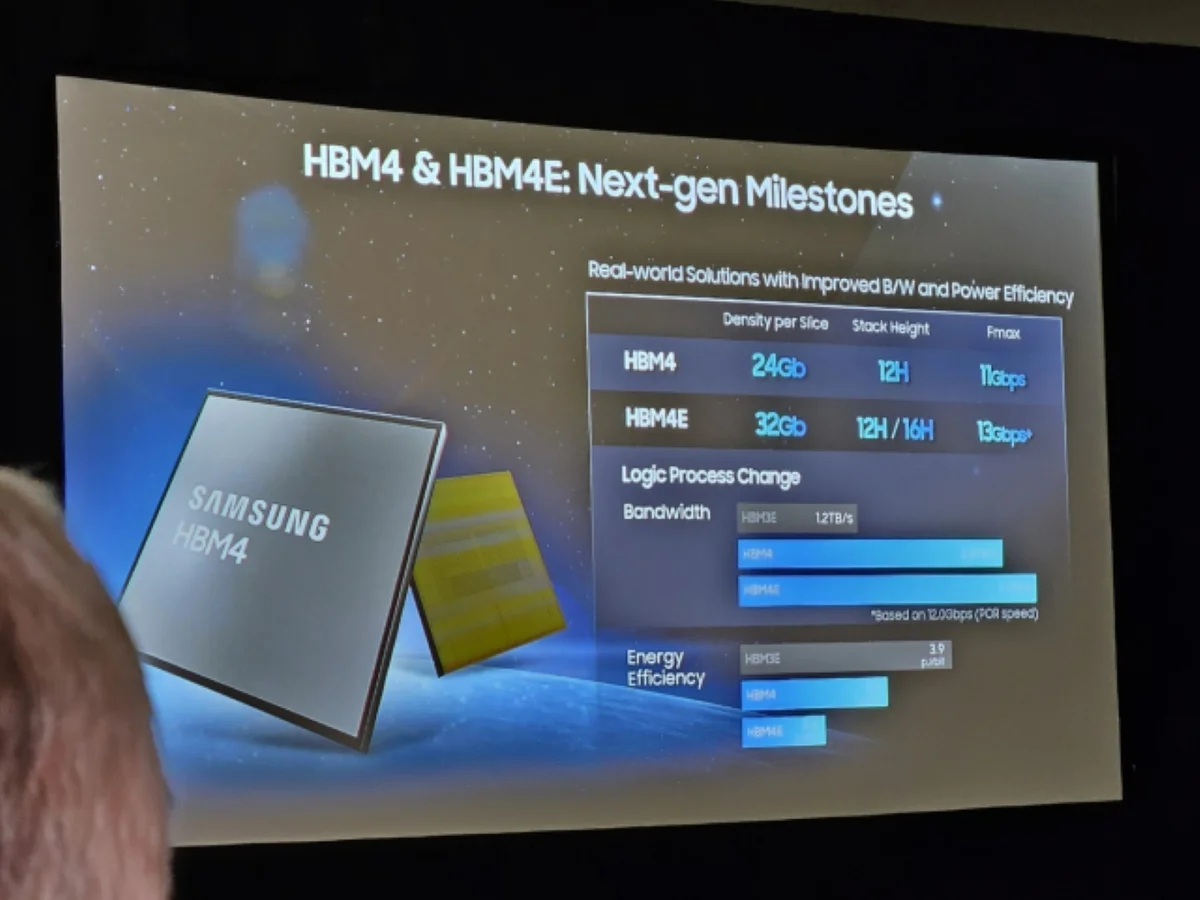

Samsung, OCP Global Summit'te paylaştığı yeni hedeflerle HBM4E'nin AI sunucularında bant genişliğinde önemli bir adım atacağını gösterdi: pin başına 13 Gbps'in üzeri, toplamda yaklaşık 3,25 TB/s bant genişliği ve iki katı enerji verimliliği hedefi..

Neden 3,25 TB/s önemli?

HBM3E'nin sunduğu performans, modern AI hızlandırıcıları için artık darboğaz olmaya başlamıştı. Samsung'un HBM4E hedefi, Vera Rubin gibi üst düzey NVIDIA hızlandırıcılarının artan bellek talebine yanıt verme amaçlı. Daha yüksek pin hızı ve 2.048 I/O ile bellek alt sistemi tek kartta çok daha fazla veri taşıyabiliyor.

Kısa not: Bu, sadece hız değil; aynı zamanda veri merkezlerinin mimarisini yeniden düşünmesi anlamına geliyor.

Teknik ve pazar etkileri

Samsung'un duyurusu, JEDEC'in HBM4 standardının ötesine geçmeyi ve üreticiler arası rekabeti hızlandırmayı hedefliyor. Micron ve SK hynix'in de HBM4/HBM4E çalışmaları var; bu durum üreticiler arasında performans ve paketleme yeniliklerini tetikleyecek. Sonuç: AI sunucularına daha yüksek geçişli, daha verimli bellek paketleri geliyor.

Anlam molası: Daha hızlı HBM, modellerin eğitilme süresini kısaltır; ancak sistem tasarımı, soğutma ve enerji yönetimi eş zamanlı güncellenmeli.

Gözlem ve kapanış

Samsung'un HBM4E hedefleri, veri merkezi tasarımcılarına ve hızlandırıcı üreticilerine yeni bir performans skalası sunuyor. Uzmanlar, bu ivmenin önümüzdeki yıllarda AI donanım yarışını daha da kızıştıracağını belirtiyor. Bu gelişme, teknolojiyle ölçeklenmiş yapay zekânın sınırlarını yeniden çizebilir.

Kısa kapanış yorumu: Bu, hafıza teknolojisinde sadece bir hızlanma değil; AI altyapısında yeni bir dönemin habercisi olabilir.

Yorumlar(0)